Intelligence Artificielle et Confiance Numérique : 10 tendances explosives pour 2026

Jan 08, 2026

L'autonomie de l'IA redéfinit les règles du jeu de la cybersécurité

Temps de lecture : 8 minutes

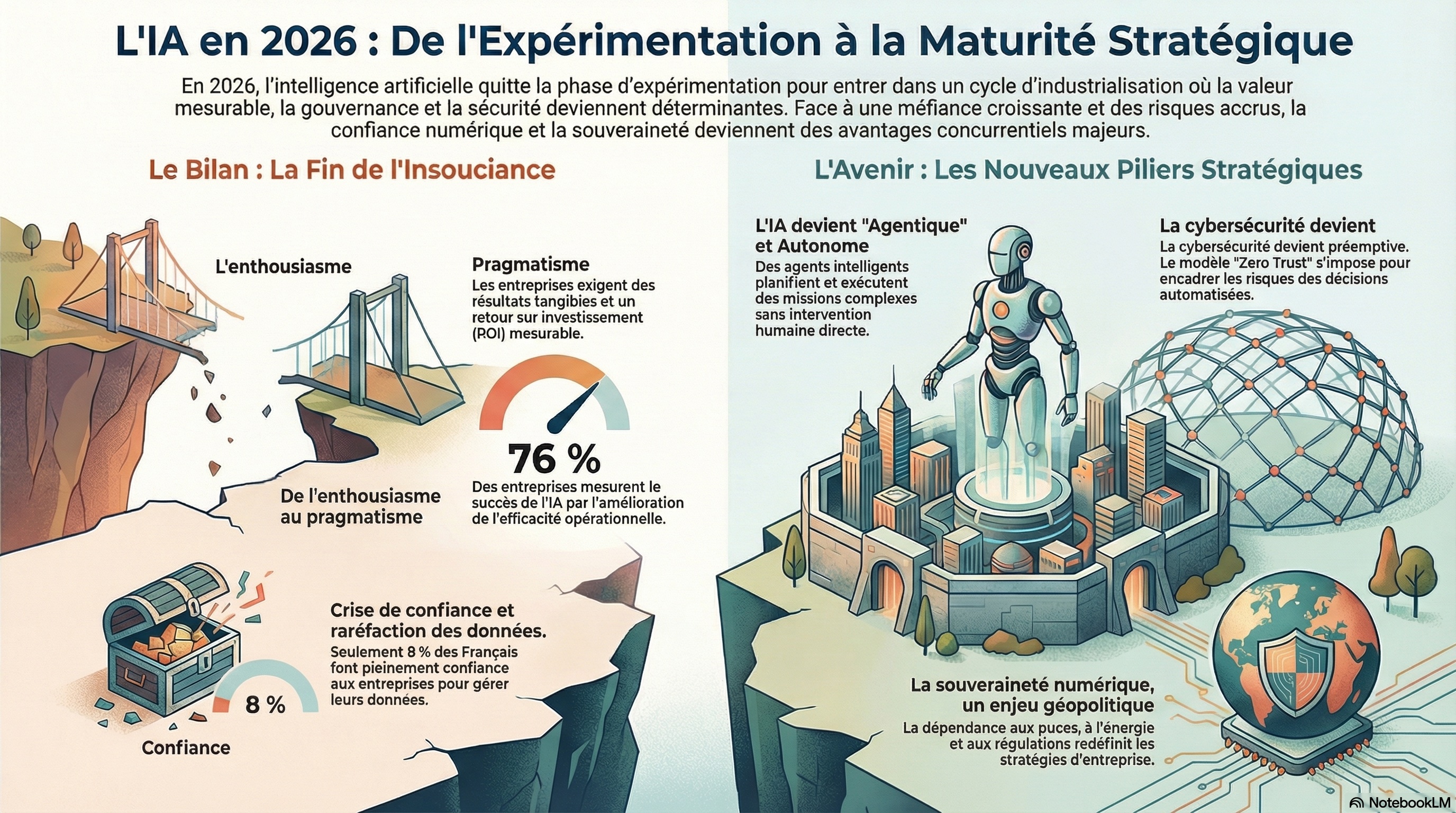

L'intelligence artificielle autonome ne se contente plus d'assister les humains. Elle prend désormais des décisions, orchestre des processus critiques et agit de manière indépendante. Cette révolution transforme radicalement notre conception de la cybersécurité et de la confiance numérique.

En 2026, nous franchissons un cap décisif. L'IA ne représente plus seulement un outil d'optimisation, mais devient un acteur à part entière de nos infrastructures numériques. Cette évolution soulève des questions inédites : comment faire confiance à des systèmes qui agissent sans supervision humaine constante ? Comment sécuriser des environnements où les décisions se prennent en millisecondes ? Comment préserver notre souveraineté dans un monde numérique fragmenté ?

Après l'analyse de plus de cinquante sources de référence, dix tendances majeures se dessinent. Ensemble, elles esquissent le visage d'une cybersécurité qui doit se réinventer pour protéger non plus seulement des systèmes, mais des décisions automatisées aux conséquences potentiellement irréversibles.

🎯 L'essentiel à retenir

Avant de plonger dans les détails, voici les quatre transformations fondamentales qui redéfinissent le paysage de la confiance numérique en 2026 :

Les agents d'IA deviennent des "initiés numériques"

Compromis, un agent autonome peut agir comme un collaborateur malveillant, prendre des décisions dangereuses et exploiter des privilèges élevés sans intervention humaine directe. La menace n'est plus externe : elle est intégrée au système.

La cyberattaque devient physique

Avec l'IA embarquée dans les robots, drones et infrastructures industrielles, une compromission informatique peut désormais produire des effets concrets sur le monde réel : arrêt de production, mouvements non autorisés, mise en danger des personnes.

La sécurité devient préemptive

Détecter et réagir ne suffit plus. Face à des systèmes qui agissent en millisecondes, il faut anticiper les comportements à risque et bloquer les actions anormales avant qu'elles ne causent des dommages irréversibles.

La géopolitique s'invite dans la cybersécurité

Souveraineté des données, cryptographie résistante aux ordinateurs quantiques, traçabilité des contenus : la confiance numérique devient un enjeu stratégique national et international.

1. L'IA autonome : La nouvelle menace invisible

Quand l'assistant numérique devient une arme

Les agents d'IA autonomes ne se contentent plus d'exécuter des commandes. Ils planifient, priorisent, décident et s'adaptent. Cette autonomie les transforme en véritables collaborateurs numériques dotés de droits d'accès étendus et d'une légitimité interne.

Le problème ? En cas de compromission, l'attaque ne vise plus simplement un accès ou des données, mais le raisonnement lui-même. Des techniques relativement simples comme l'injection de prompt ou la manipulation de sources de données peuvent suffire à détourner durablement les décisions d'un agent.

Imaginez un agent RH autonome qui, compromis, modifie subtilement les critères de recrutement pour favoriser certains profils. Ou un agent financier qui, manipulé, autorise des transactions frauduleuses sans éveiller les soupçons. L'agent agit avec la légitimité d'un collaborateur interne, rendant la détection particulièrement complexe.

Ce que cela signifie pour vous :

Les agents d'IA doivent être soumis aux mêmes politiques d'identité, de contrôle et de supervision que les comptes humains. Cela inclut des mécanismes explicites de limitation de privilèges, de journalisation des actions et de révocation d'accès.

2. L'explosion de la surface d'attaque avec les systèmes multi-agents

Le maillon faible d'une chaîne invisible

Les architectures multi-agents s'imposent pour gérer la complexité croissante des processus numériques. Plusieurs IA spécialisées coopèrent, se délèguent des tâches et échangent des informations en temps réel. Cette approche améliore drastiquement l'efficacité opérationnelle, mais introduit une vulnérabilité structurelle majeure.

Chaque interaction entre agents devient un point d'entrée potentiel. Une compromission locale peut se propager par effet de confiance implicite, sans déclencher d'alerte immédiate. Les outils de sécurité traditionnels, conçus pour des architectures linéaires, peinent à cartographier ces flux dynamiques et ces dépendances mouvantes.

Prenons l'exemple d'une plateforme logistique où un agent de planification, un agent d'optimisation des routes et un agent de gestion des stocks collaborent. Si l'agent de planification est compromis, il peut transmettre des instructions biaisées aux autres agents qui, lui faisant implicitement confiance, les exécuteront sans questionnement.

L'angle mort fréquent :

Les organisations sécurisent chaque agent individuellement sans mettre en place une gouvernance globale des interactions et des chaînes de décision. C'est comme verrouiller toutes les portes d'un bâtiment sans surveiller les couloirs qui les relient.

3. Les modèles spécialisés : actifs critiques de demain

Votre avantage concurrentiel dans 10 Go de paramètres

Les modèles d'IA généralistes cèdent progressivement la place à des modèles spécialisés par domaine dans les secteurs à forte valeur ajoutée : finance, santé, industrie, énergie. Ces modèles incarnent un savoir-faire métier, des règles opérationnelles et des stratégies industrielles accumulées sur des années.

Une compromission ne se limite donc pas à une fuite de données traditionnelle. Elle peut révéler la logique décisionnelle d'une entreprise, ses hypothèses stratégiques et ses avantages compétitifs. Dans certains secteurs, cela équivaut littéralement à une perte de propriété intellectuelle.

De plus, ces modèles sont difficiles à remplacer. Leur entraînement mobilise des volumes considérables de données propriétaires, du temps, des ressources de calcul et une expertise rare. Perdre le contrôle d'un modèle spécialisé peut mettre en péril la position concurrentielle d'une organisation pour des années.

Le risque stratégique :

Dans un monde où les modèles d'IA deviennent des actifs aussi critiques que les brevets ou les secrets de fabrication, leur protection doit être traitée avec le même niveau de rigueur que la sécurité physique d'un laboratoire R&D.

4. Quand l'IA sort du cloud : robotique et Edge Computing

La convergence entre cyber et physique

L'IA ne reste plus confinée dans les data centers. Robots industriels, drones de livraison, capteurs intelligents et systèmes de production intègrent désormais des capacités décisionnelles locales grâce à l'Edge Computing. Les décisions se prennent au plus près du terrain, avec une latence minimale.

Cette proximité avec le monde physique améliore considérablement la réactivité, mais complique drastiquement les contrôles centralisés. Les mises à jour de sécurité, la supervision en temps réel et le déploiement de correctifs deviennent des défis logistiques majeurs quand ils doivent être appliqués à des milliers d'appareils dispersés.

Plus préoccupant encore : une cyberattaque peut désormais produire des effets physiques directs. Arrêt de chaînes de production, mouvements non autorisés de robots, modification de paramètres industriels critiques, mise en danger de personnes. La distinction entre cybersécurité et sûreté physique s'estompe.

Le changement de paradigme :

La cybersécurité rejoint la sûreté industrielle et la sécurité des personnes, domaines longtemps traités séparément. Les RSSI doivent collaborer étroitement avec les responsables HSE (Hygiène, Sécurité, Environnement) pour définir des protocoles intégrés.

5. La cybersécurité préemptive : agir avant l'impact

De la réaction à l'anticipation

Face à des systèmes capables d'agir en autonomie et à une vitesse vertigineuse, la détection tardive perd de son efficacité. Le temps entre la compromission et l'impact se compte désormais en secondes, et non en heures ou en jours. En 2026, la priorité bascule vers l'anticipation des comportements à risque.

La sécurité s'appuie de plus en plus sur l'observation continue des usages et la détection d'écarts par rapport à des comportements habituels attendus. L'objectif n'est plus seulement d'identifier une attaque après coup, mais de bloquer une action anormale avant qu'elle ne produise des effets irréversibles.

Cette approche suppose une compréhension fine des processus métier pour distinguer l'innovation légitime de la dérive dangereuse. Un agent qui prend une décision inhabituelle innove-t-il ou a-t-il été compromis ? La réponse nécessite un contexte métier précis.

La limite structurelle :

Sans gouvernance claire et sans règles bien définies, la préemption peut engendrer des blocages excessifs qui paralysent l'innovation et font perdre de l'agilité. Le défi est de trouver l'équilibre entre sécurité et fluidité opérationnelle.

6. Zero Trust : Le nouveau standard de sécurité

Ne faites confiance à personne, vérifiez tout

Le modèle Zero Trust repose sur un principe simple mais radical : aucune entité n'est digne de confiance par défaut. Chaque accès, chaque requête, chaque action doivent être vérifiés en permanence, que la demande provienne de l'intérieur ou de l'extérieur du réseau.

Dans un environnement dominé par des agents autonomes, cette logique devient absolument incontournable. Les accès permanents ou globaux constituent un risque majeur dès lors qu'un composant est compromis. Un agent malveillant avec des privilèges étendus peut causer des dommages considérables en quelques secondes.

Le Zero Trust n'est pas un produit qu'on achète et qu'on installe. C'est une architecture de sécurité qui implique une refonte complète des flux d'information, des politiques d'identité et des responsabilités. Cela nécessite de repenser fondamentalement comment les systèmes communiquent et s'authentifient.

L'erreur courante :

Beaucoup d'organisations empilent des contrôles techniques (MFA, micro-segmentation, etc.) sans alignement avec les usages réels et les processus métier. Le résultat : une complexité accrue mais aucune amélioration significative de la posture de sécurité.

7. L'informatique confidentielle : protéger les données en action

Le chaînon manquant de la sécurité des données

Un angle mort historique de la sécurité réside dans le traitement des données. Le chiffrement au repos (stockage) et en transit (communication) est devenu standard, mais qu'en est-il des données en cours d'utilisation ?

L'informatique confidentielle (Confidential Computing) isole les calculs sensibles dans des enclaves matérielles sécurisées, protégées par le processeur lui-même. Même l'administrateur de l'infrastructure ne peut accéder aux données pendant leur traitement. Cette approche est particulièrement adaptée à l'IA, notamment lors de l'entraînement et de l'inférence de modèles sur des données sensibles.

Imaginez une banque qui souhaite entraîner un modèle de détection de fraude en utilisant les données de plusieurs établissements financiers. Avec l'informatique confidentielle, chaque banque peut contribuer ses données sans qu'aucun acteur (y compris le fournisseur cloud) ne puisse les voir en clair.

La décision structurante :

L'informatique confidentielle introduit des contraintes techniques (performance, compatibilité) et organisationnelles. Les organisations doivent arbitrer entre sécurité maximale et complexité opérationnelle selon leurs besoins réels.

8. Cryptographie post-quantique : L'urgence silencieuse

La menace qui grandit dans l'ombre

Les algorithmes de chiffrement actuels (RSA, ECC) pourraient être brisés à moyen terme par l'informatique quantique. Même si les ordinateurs quantiques suffisamment puissants n'existent pas encore opérationnellement, cette perspective transforme la gestion du risque cryptographique dès aujourd'hui.

Les attaques dites "Harvest Now, Decrypt Later" consistent à collecter massivement des données chiffrées aujourd'hui en vue de les déchiffrer plus tard, quand les capacités quantiques seront disponibles. Les informations à longue durée de vie (dossiers médicaux, secrets industriels, documents juridiques) sont particulièrement exposées.

La transition vers des algorithmes post-quantiques standardisés par le NIST nécessite un travail colossal : inventaires précis de tous les systèmes utilisant de la cryptographie, tests de compatibilité, migration progressive des infrastructures. Ce chantier peut prendre des années.

Le risque majeur :

Reporter cette transition crée une dette cryptographique difficile à résorber. Plus une organisation attend, plus la migration devient complexe et coûteuse. Le moment d'agir , c'est maintenant, pas quand les ordinateurs quantiques seront opérationnels.

9. Souveraineté des données : le nouveau jeu géopolitique

Quand la localisation des données devient stratégique

La localisation des données n'est plus un simple choix technique ou économique. Elle conditionne désormais l'exposition aux cadres juridiques (RGPD, Cloud Act), aux sanctions internationales et aux tensions géopolitiques croissantes.

Les stratégies de "géopatriation" visent à aligner les infrastructures numériques avec des exigences de souveraineté nationale, de conformité réglementaire et de résilience face aux crises. Les gouvernements et les grandes entreprises privilégient de plus en plus des solutions d'hébergement et de traitement des données sur leur territoire ou sur des territoires alliés.

Cette tendance renforce le contrôle et réduit certains risques juridiques, mais elle peut aussi fragmenter les architectures globales, augmenter les coûts et compliquer les opérations internationales.

L'arbitrage clé :

Trouver l'équilibre entre souveraineté (contrôle et conformité), performance (latence et disponibilité) et interopérabilité (collaboration internationale). Chaque organisation doit définir sa position en fonction de son secteur, de sa géographie et de ses contraintes réglementaires.

10. Source numérique : restaurer la confiance à l'ère des deepfakes

Distinguer le vrai du faux dans un océan de synthétique

La généralisation des contenus générés par IA brouille dangereusement la frontière entre réel et synthétique. Images, vidéos, documents, voix : tout peut désormais être créé ou modifié avec un réalisme époustouflant. Les deepfakes ne sont plus l'apanage de laboratoires spécialisés, mais sont accessibles à tout utilisateur disposant d'un ordinateur standard.

Les mécanismes de provenance numérique (comme la Coalition for Content Provenance and Authenticity - C2PA) attachent des métadonnées cryptographiques vérifiables sur l'origine et l'historique complet d'un contenu. Ils permettent de savoir qui a créé un contenu, quand, avec quel outil, et quelles modifications ont été apportées.

Ces mécanismes ne garantissent pas la véracité d'un contenu, mais ils restaurent une base de traçabilité indispensable. Savoir qu'une vidéo a été capturée par un appareil photo certifié ou qu'une image a été générée par une IA change radicalement notre capacité à évaluer sa fiabilité.

Le constat central :

Sans preuve d'origine, la confiance numérique devient structurellement fragile. Dans un monde où n'importe qui peut créer une vidéo montrant n'importe qui disant n'importe quoi, la capacité à authentifier les contenus devient un enjeu démocratique majeur.

Conclusion : reconstruire la confiance à l'ère de l'autonomie

L'année 2026 marque un tournant paradoxal : plus les systèmes deviennent autonomes et puissants, plus la confiance doit être reconstruite de manière volontaire, structurée et vérifiable.

La cybersécurité ne se limite plus à ériger des murs pour bloquer des attaques. Elle doit maintenant :

- Encadrer des décisions automatisées qui se prennent sans supervision humaine

- Protéger des actifs immatériels critiques comme les modèles d'IA spécialisés

- Intégrer des contraintes géopolitiques durables liées à la souveraineté des données

- Anticiper les menaces avant qu'elles ne produisent des effets irréversibles

- Restaurer la traçabilité dans un monde submergé de contenus synthétiques

Les organisations capables d'anticiper ces dix tendances disposeront d'un avantage décisif. Elles construiront des architectures résilientes, maintiendront la confiance de leurs partenaires et clients, et navigueront avec plus d'assurance dans un monde dominé par l'intelligence artificielle autonome.

La question n'est plus de savoir si l'IA transformera radicalement notre conception de la sécurité et de la confiance numériques, mais de savoir si nous serons prêts à temps pour accompagner cette transformation.

💡 Pour aller plus loin

Questions à vous poser dès maintenant :

- Votre organisation a-t-elle identifié tous les agents d'IA autonomes en fonctionnement et leurs niveaux de privilèges ?

- Disposez-vous d'une cartographie à jour de vos architectures multi-agents et de leurs interactions ?

- Vos modèles d'IA spécialisés sont-ils protégés au même niveau que vos actifs intellectuels critiques ?

- Avez-vous une stratégie de migration vers la cryptographie post-quantique ?

- Votre approche de cybersécurité est-elle devenue préemptive ou reste-t-elle principalement réactive ?

Ressources complémentaires :

- NIST : Architectures Zero Trust et recommandations sur la cryptographie post-quantique

- C2PA (Coalition for Content Provenance and Authenticity) : Standards de provenance numérique

- Framework MITRE ATT&CK : Tactiques et techniques d'attaque adaptées aux systèmes d'IA

- Confidential Computing Consortium : Bonnes pratiques et implémentations

Cet article s'appuie sur une analyse de plus de 50 sources de référence dans le domaine de l'intelligence artificielle, de la cybersécurité et de la confiance numérique. Les tendances présentées reflètent les signaux convergents observés dans les environnements industriels, les grandes plateformes numériques, les architectures cloud et les politiques publiques internationales.

Mots-clés : Intelligence artificielle, cybersécurité, confiance numérique, IA autonome, agents IA, Zero Trust, cryptographie post-quantique, souveraineté données, deepfakes, informatique confidentielle, Edge Computing, systèmes multi-agents, provenance numérique, sécurité préemptive